Hardware

Per copiare l'intera pagina in formato ZIP (2 MB)

Per ottenere maggiori informazioni si veda anche:

http://www.cortesi.hostdns.it/

http://www.4print.org/Asp/default.asp

http://www.acszone.com/ voce hardware e links

http://www.geocities.com/Vienna/Strasse/9066/index.htm (alcune voci sono obsolete)

Le voci del glossario sono tratte da:

Autore del Dizionario Informatico: Francesco Longo

URL Dizionario Informatico: http://www.dsi.unive.it/~flongo/diz

Copyright 1997 by Francesco Longo, flongo@dsi.unive.it

Le descrizioni tecniche sono tratte dai siti delle case produttrici e di

vendita.

La scelta delle attrezzature qui descritte è dovuta ESCLUSIVAMENTE alla

necessità di indicare alcune importanti caratteristiche tecniche.

I prodotti qui illustrati non necessariamente costituiscono la migliore

scelta, né il miglior compromesso prezzo/prestazioni.

Il computer e i suoi componenti

Il processore (CPU)

BREVE STORIA DI WINDOWS:

Si veda anche: http://www.acszone.com/

voce: hardware Componenti La memoria RAM SDRAM: e' una memoria di tipo sincrono, cioe' rispetta un tipo di

sincronia con il segnale di clock

del processore. Questa

particolarita' riduce i tempi di accesso a tale memoria. • una memoria di archiviazione, che serve a registrare il sistema

operativo, i programmi ed i documenti. Questo tipo di memoria conserva

permanentemente le informazioni registrate. Sono memorie di archiviazione il

disco rigido, i dischetti, i CD-ROM... (vedi capitolo “Le unità di memoria

di massa”); La memoria di lavoro si divide in due parti:

• memoria ROM, che serve ad accendere il personal; Quando si accende un personal, si attiva la memoria ROM, che da vita al

computer e che provvede a caricare il sistema operativo dal disco rigido

(memoria di archiviazione) alla memoria RAM. Qui il sistema operativo si

installa e “prende possesso” del computer. Memoria ROM

La memoria ROM, dall’inglese Read Only Memory, è un tipo di memoria

permanente, non “volatile”, e che non può essere modificata dall’utente

del computer. Firmware e BIOS Oltre alla memoria ROM presente sulla scheda madre, un computer può avere

anche altra memoria ROM inclusa in schede specializzate inserite nei

connettori. Questo tipo di schede hanno spesso bisogno di un programma

apposito per poter svolgere le proprie funzioni. Niente di più naturale, ed

economico, che includere questo programma in una ROM che, saldata alla scheda

stessa, non corre il pericolo di danneggiarsi o di essere persa come potrebbe

accadere ad un dischetto.

Flash-ROM e Boot-ROM Memoria RAM

Oltre ai chip della memoria ROM, che è di sola lettura, esistono altri

chip di memoria. Questa volta si tratta di memoria vuota, a disposizione

dell’utente. Anzi: a disposizione del computer, il quale ha necessità, per

poter eseguire un programma ed elaborare dei documenti, di caricare in memoria

sia il programma che i documenti. Volatilità della RAM Dimensione della RAM Espansione della RAM Non tutte le memorie RAM vanno bene per tutti i computer. Chiedendo la

memoria RAM aggiuntiva al momento dell’acquisto, il venditore stesso

provvederà ad installarla e collaudarla. Effettuando l’acquisto delle SIMM

in seguito, è invece indispensabile rispettare le caratteristiche richieste

esposte nel manuale della macchina. Esistono tipi diversi di moduli di memoria

RAM e la corrispondenza con il modello richiesto deve essere perfetta. Espandere la memoria di un computer portatile è ancora più complicato. Lo

spazio all’interno è limitato e quindi le schede devono essere piccole e

sottili, mentre la costante necessità di risparmiare il consumo di energia

costringe all’uso di componenti particolari. Non è facile valutare la necessità di memoria. Di certo la quantità di

RAM va collegata da un lato al microprocessore utilizzato e dall’altro al

sistema operativo ed al tipo di programmi con i quali vogliamo lavorare. Memoria virtuale Il metodo utilizzato dai programmi di utilità per la creazione della

memoria virtuale è diverso. Invece di ricorrere subito alla registrazione su

disco rigido, il programma di utilità compatta i programmi non attivi e li

comprime nella stessa RAM. Questa operazione crea già abbastanza spazio

libero senza grosse perdite di tempo, non essendoci operazioni di

scrittura/lettura su disco. Con la memoria virtuale, quindi, possiamo caricare in memoria molti più

programmi e documenti di quanti la RAM fisica permetterebbe. L’unico

requisito è che ciascun singolo programma non superi, da solo, la capacità

della memoria fisica. Se abbiamo 8Mb di RAM espansa a 16Mb virtuali, non

possiamo caricare nessun programma che, da solo, richieda più di 8Mb.

Possiamo caricarne tre da 4Mb ciascuno, ma non uno da 9Mb.

Memoria cache

Alcuni computer sono dotati di una scheda di memoria cache. Si tratta di

uno speciale modulo di memoria RAM, quindi che si cancella ad ogni

spegnimento, ma che non è direttamente utilizzabile per caricare programmi da

eseguire come la normale RAM. Processore DMA

Il processore Direct Memory Access gestisce il flusso di dati fra la

memoria del computer ed alcune periferiche abilitate al DMA, alleggerendo il

lavoro del microprocessore. Lo scambio di dati con le periferiche è quindi più

veloce, perché ha un diretto accesso in memoria e non deve attraversare

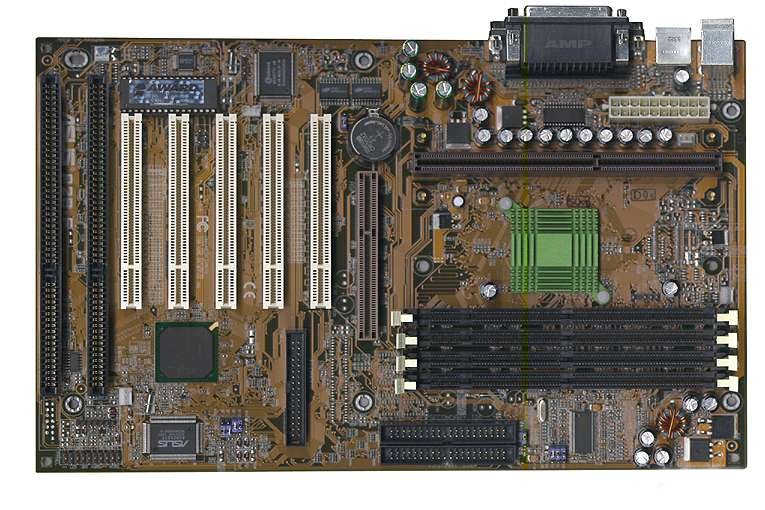

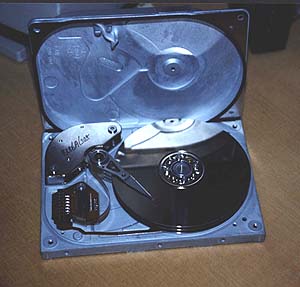

l'architettura del microprocessore. http://www.geocities.com/Vienna/Strasse/9066/parte2/p202.htm La scheda 'madre' (motherboard) Il disco 'flessibile' (floppy disk)

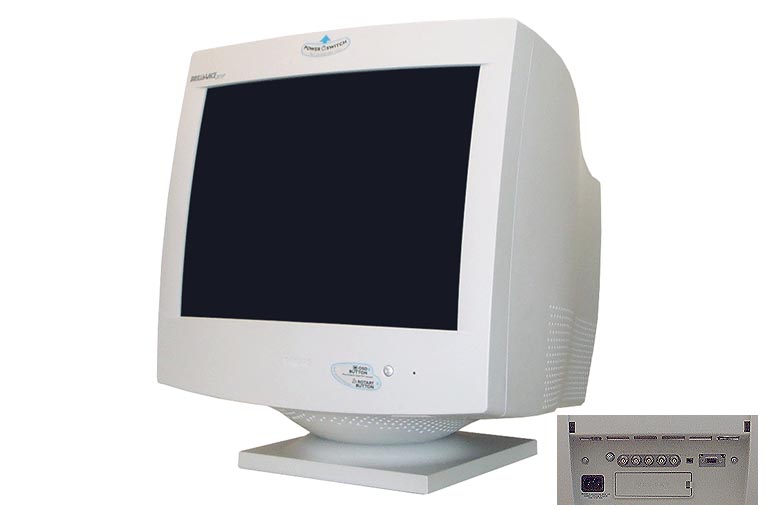

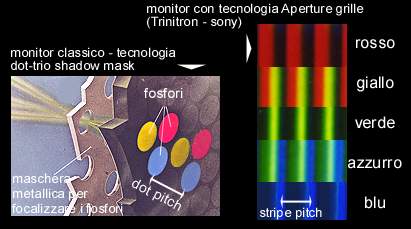

Il disco 'rigido' (hard disk) La tastiera Il mouse La tavoletta grafica (digitizer) Il monitor La risoluzione nei monitor dipende dal numero di pixel

che questo riesce a visualizzare. Le risoluzioni piu' comuni sono le seguenti:

640 x 480 (pixel), 800 x 600, 1024 x 768, 1152 x 870, 1280x1024 oppure 1600 x

1200. I monitor Multisync possono visualizzare piu' risoluzioni. Poiche'

nelle alte risoluzioni le immagini, i caratteri, le icone, le windows ecc. si

rimpiccioliscono, al crescere della risoluzione e' possibile operare su un area

piu' vasta dello schermo. Di conseguenza se gli elementi visualizzati assumono

dimensioni ridotte perche' si e' optato per una risoluzione piu' alta, e'

consigliabile un monitor con dot

pitch o stripe pitch basso. I termini dot o stripe pitch indica la

distanza tra un fosforo e quello successivo dello stesso colore, espressa in

millimetri. I monitor che offrono maggior nitidezza solitamente hanno un dot

pitch sui valori di 0,25. RGB: acronimo ing. per Red, Green, Blu ossia il rosso, il

verde e il blu. Bastano solo questi tre colori "fondamentali", per

definire tutti gli altri colori sul monitor. Questo puo' succedere perche' il

mescolamento dei colori nella luce e' un processo additivo, ossia le diverse

lunghezze d'onda elettromagnetica dei tre colori vengono sommate insieme. E' interessante notare come i colori primari di un tipo di rappresentazione

corrispondano a quelli secondari dell'altra rappresentazione, ove per

rappresentazione intendiamo RGB o CYMK. I monitor creano le immagini accendendo i fosfori colorati presenti sullo

schermo. Gli elettroni, irradiati dal cannone del monitor, colpiscono i

fosfori che a loro volta emettono luce. Ogni punto (pixel)

sullo schermo e' definito da questi tre fosfori. Una panoramica sulle tecnologie CRT utilizzate per la realizzazione

dei monitor. Le nuove linee guida per i prodotti che affronteranno il mercato del

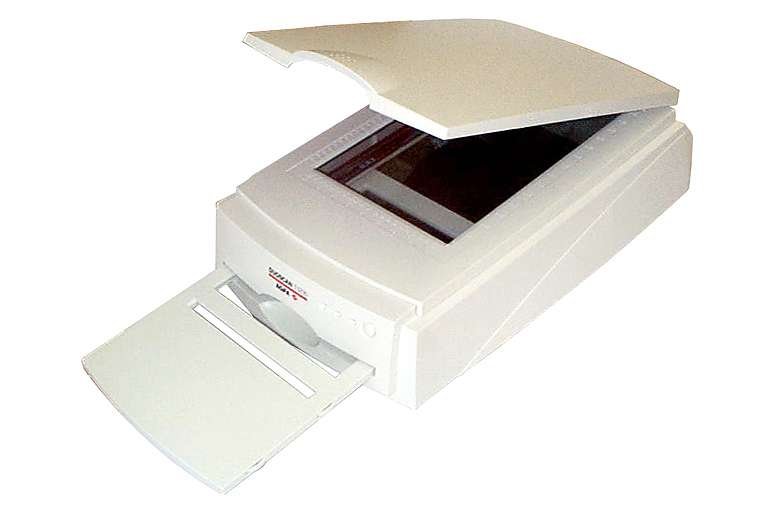

nuovo millennio. http://www.4print.org/Asp/4print051.asp La scheda grafica Lo scanner • scanner a ripresa in piano; Scanner a ripresa in piano

Scanner a rullo

Scanner a tamburo

Scanner su stativo

Scanner manuale

Caratteristiche tecniche degli scanner

• risoluzione ottica: è la risoluzione fisica dello scanner. In

genere è di 300 punti per pollice (dpi) per uno scanner a ripresa in piano e

1200 dpi per uno scanner per pellicole; Consigli per l’uso degli scanner

Riguardo alla risoluzione, è meglio che sia la più alta possibile. Sempre

parlando di risoluzione massima, perché quella reale da utilizzare durante la

ripresa deve essere decisa in dipendenza dell’immagine da digitalizzare o

del suo uso. Acquisendo immagini da inserire in pagine Internet, ad esempio,

la risoluzione deve essere di 72 dpi. I programmi di ripresa ed i driver consentono di effettuare la ripresa

dell’immagine effettuando contemporaneamente una riduzione od un

ingrandimento della stessa. Le dimensioni dell’immagine si possono

modificare in qualunque momento con i programmi di ritocco fotografico, ma

registrare sul disco una foto già ridotta sin dall’inizio è un notevole

risparmio di spazio. Inoltre, riducendo o, ancora peggio, ingrandendo dopo la

ripresa, si rischia che l’immagine venga distorta o sfocata. http://www.geocities.com/Vienna/Strasse/9066/parte2/p211.htm Il modem (modulatore/demodulatore) Modulazione e demodulazione

Il modem viene collegato da una parte alla porta seriale del computer,

dall’altra alla linea telefonica. Con un software di comunicazione il modem

è in grado di selezionare un numero telefonico, all’altro capo del quale si

trova un secondo modem, collegato da parte sua ad un computer sul quale è in

esecuzione un software di comunicazione. Mentre il flusso di dati può viaggiare fino a 230’000 bit al secondo se

i due computer sono in connessione diretta, la velocità massima permessa

dalle linee telefoniche è di 56’600 bit per secondo, ma i disturbi, le

interferenze e le difficoltà di ricezione spesso costringono ad utilizzare

velocità di 28’800 bit per secondo, a addirittura inferiori.

Protocolli

Come abbiamo visto parlando delle porte del computer, la trasmissione

seriale di dati impone la scelta del protocollo, che non riguarda solamente la

velocità, ma anche l’esistenza di codici di controllo ed il formato del

flusso dei bit. Commutata e ISDN

I modem si possono dividere in due grandi settori: quelli per linee

telefoniche commutate e quelli per linee telefoniche ISDN. Avere una linea ISDN è ovviamente molto più costoso, tuttavia ha il

vantaggio di avere due numeri telefonici del tutto indipendenti e di

consentire un minore impegno di linea (e quindi un minor consumo di scatti) se

si usa spesso il modem (di tipo ISDN) o il fax (però di tipo ISDN anch'esso).

Utilizzare una linea ISDN con un modem normale (o con un fax normale) non

porta ad alcun vantaggio complessivo.

Linee dedicate

Diverso è il discorso delle linee dedicate. Si tratta di collegamenti

telefonici permanenti, sempre attivi, che servono ad utilizzatori

"intensi" come può essere il computer centrale di una banca,

collegato su linee dedicate a tutte le agenzie sul territorio nazionale. Caratteristiche tecniche

I modem per linea commutata in commercio hanno caratteristiche comuni:

- comandi Hayes, così chiamati dalla ditta americana che li elaborati. Si

tratta di un linguaggio di comandi con il quale il computer dirige il

funzionamento del modem; Le apparecchiature più recenti presentano, oltre ad un costo più

contenuto rispetto ai vecchi modelli, ed a dimensioni più piccole, alcune

innovazioni tecnologiche:

- autoriconoscimento del protocollo: il modem è in grado di riconoscere il

protocollo usato dal modem corrispondente e di regolarsi da solo sullo stesso

protocollo; In coincidenza con il successo dei computer portatili, sono stati prodotti

un buon numero di modem portatili che alle caratteristiche tecniche più

diffuse aggiungono:

- adattabilità, grazie alla presenta di tipi diversi di connettori

telefonici, compresi i telefoni pubblici, quelli utilizzati negli alberghi e

gli apparecchi cellulari; Indipendenti ed a schede

I modem sono apparecchiature standardizzate, utilizzabili da tutti i

computer. Cambiando personal è possibile conservare lo stesso modem.

Addirittura il cambio di ambiente, da quello DOS a quello Macintosh, permette

di usare lo stesso modem con la sola sostituzione del cavetto di collegamento

a causa della diversità della porta seriale. Modem/telefax

I modem/telefax sono molto semplici nell’uso, soprattutto in fase di

trasmissione. La differenza di costo con un modem normale non è rilevante. Inoltre il

modem/telefax consente un grosso vantaggio rispetto alle apparecchiature

telefax: la trasmissione automatica. Considerazioni finali

Si utilizza il modem per collegare due computer che devono scambiarsi dati,

come fra la filiale di una ditta e la sede centrale per aggiornare il

magazzino, gli ordini, la contabilità. - Cerved, centro calcolo delle Camere di Commercio: detiene tutti i dati

sociali di tutte le società ed aziende commerciali di capitali e di persone

esistenti in Italia, compresi i bilanci, e gli organi sociali. Ha inoltre

l’elenco di tutti gli effetti bancari od assegni andati in protesto in

Italia, con nome del traente. Sono inoltre a disposizione dati sul commercio

con l’estero e sulle fiere internazionali; Oltre all’attività di consultazione di archivi di informazioni residenti

su computer lontani, il modem serve anche per collegarsi attivamente a servizi

telematici come:

- Postel, servizio di posta elettronica dell’Amministrazione Postale:

consente l’invio di lettere, circolari, fatture, effetti e telex

direttamente dal computer, garantendo una consegna a destinazione molto più

celere del servizio ordinario delle poste. Il servizio Postel, infatti, si

basa su una ventina di elaboratori nelle maggiori città italiane. Una lettera

scritta su un computer a Milano, per un destinatario a Roma, viene inviata

all’elaboratore Postel di Milano che la inoltra al suo omologo di Roma, il

quale provvede a stamparla direttamente all’interno del centro postale di

smistamento. Nell’arco di 12/24 ore la lettera è consegnata. Con un

sovrapprezzo è possibile utilizzare il servizio Postacelere per una consegna

entro 6 ore.

In campo internazionale è possibile accedere a banche dati di ogni genere,

di consultazione scientifica, finanziaria, industriale, medica, ma anche

servizi di assistenza e consulenza organizzati dalle case produttrici di

computer o dalle software house che in questo modo forniscono ai propri

clienti informazioni sempre complete ed aggiornate. Ci si può collegare alle

agenzie stampa come Associated Press o Roiter per i lanci di notizie in

diretta, o per seguire particolari avvenimenti. Anche il tempo libero ha la sua quota di comunicazione elettronica.

Numerosi servizi telematici sono gratuiti, od a basso costo, e servono allo

scambio di messaggi ed esperienze hobbistiche o personali. Vi sono poi basi di

dati con trame di film o di telefilm e soap opera, classifiche musicali o

letterarie, giochi di simulazione o scacchi in corso fra partecipanti di

vari continenti. Collegamenti a grande distanza

Spesso gli elaboratori a cui è necessario collegarsi sono distanti

parecchi chilometri e una chiamata telefonica diretta farebbe arrivare

bollette stratosferiche per i costi della teleselezione. Per fortuna esiste un

particolare servizio della SIP che consente il collegamento di computer a

costi ridotti: la rete Itapac. http://www.geocities.com/Vienna/Strasse/9066/parte2/p210.htm Il lettore CD e DVD Si veda anche: http://www.acszone.com/

voce: hardware DVD:

Lettori e Masterizzatori Il masterizzatore La stampante CARATTERISTICHE:

IMPIEGO:

tratto da: http://az.cs.unitn.it/AZ/FondamInform_1995-96/Studenti/apaties/stp.con.html

CARATTERISTICHE:

IMPIEGO:

tratto da: http://az.cs.unitn.it/AZ/FondamInform_1995-96/Studenti/apaties/stp.con.html Tra tecnologia e applicazione: alcune indicazioni per la scelta del

giusto dispositivo. Il reale costo della pagina stampata è uno dei principali punti di

discussione. I parametri per una corretta valutazione. http://www.4print.org/Asp/4print048.asp Il plotter CARATTERISTICHE:

tratto da: http://az.cs.unitn.it/AZ/FondamInform_1995-96/Studenti/apaties/stp.con.html Fotocamera digitale La fotocamere digitali

I dorsi digitali

http://www.geocities.com/Vienna/Strasse/9066/parte2/p211.htm La videocamera

In ogni personal computer vi sono due tipi di memoria:

• una memoria di lavoro, che serve per accendere il computer, per caricare

il sistema operativo e per lavorare con i programmi ed i documenti. La memoria

di lavoro è costituita da chip montati sulla scheda madre o su moduli

aggiuntivi.

• memoria RAM, che serve a lavorare.

Quando vogliamo lavorare con un programma, cioè quando lo mandiamo in

“esecuzione”, oppure quando “apriamo” un documento per modificarlo, il

sistema operativo legge dal disco rigido il programma e/o il documento e li

carica nella memoria RAM. Qui possiamo lavorare con il programma, modificare

un documento, crearne uno nuovo.

Tutto il lavoro sui documenti si svolge nella memoria RAM e deve essere

considerato provvisorio finché non venga “salvato”, cioè non si chieda

al sistema operativo di registrare il lavoro effettuato su un disco rigido o

su un’altra memoria di archiviazione.

La memoria RAM, infatti, deve essere continuamente tenuta in vita da impulsi

elettrici ed in mancanza di questi, quando il computer viene spento, perde

tutti i dati caricati. Per questo la memoria RAM viene chiamata

“volatile”: basta poco, una mancanza di elettricità, qualcuno che

inciampa nel filo della corrente, perché tutto il lavoro svolto fino a quel

momento scompaia come una scritta sulla sabbia per un colpo di vento.

La memoria ROM, invece, servendo proprio ad accendere il personal, rimane

sempre inalterata.

Quando il computer ci viene venduto possiede già una piccola dotazione di

software intallato nella memoria ROM. Software, ripetiamo, che è registrato

permanentemente e non può essere né cancellato, né modificato.

Questo software viene chiamato firmware, cioè saldo, fisso, e comprende anche

tutte le basilari istruzioni utilizzate dai programmi per avere accesso ai

diversi componenti hardware come il video, il mouse, le porte di comunicazione

ed i dischi floppy o rigidi.

Fa parte del firmware, ad esempio, il BIOS, cioè quel gruppo di istruzioni

che consente ai diversi processori di attivarsi al momento dell’accensione

del computer, di rispondere agli impulsi del clock e di effettuare un piccolo

autotest di funzionamento. Infine viene letto il sistema operativo presente

sul disco rigido e, dopo essere stato caricato nella memoria RAM, gli viene

ceduto il controllo del sistema.

La ROM è definita nella configurazione base di ciascun computer e la sua

grandezza non ha molto a che vedere con le prestazioni del personal, con la

sua velocità di elaborazione o la sua potenza. Per quanto riguarda il

firmware, esso viene installato dalla ditta costruttrice della macchina e non

è modificabile.

Anche se spesso la presenza e la quantità della memoria ROM sulla scheda

madre o sulle schede accessorie viene evidenziata nei manuali o nei depliant

dei computer, l’utente non ha alcun beneficio nel conoscerne le dimensioni o

le caratteristiche. L’attività del firmware presente nella memoria ROM è

del tutto invisibile.

Nei personal più vecchi era necessario sostituire la ROM, per sostituire il

firmaware contenuto, quando si voleva aggiungere un dispositivo hardware che

non era previsto quando era stato costruito il computer ed installato il

firmware. E’ una operazione, ad esempio, che deve fare chi voglia collegare

un disco da 3,5 pollici ad un vecchio computer con 8086, nato quando questi

non esistevano ancora e si usavano i dischi da 5 e 1/4.

Con i sistemi attuali, invece, tale funzione di compatibilità con periferiche

nuove viene svolto da porzioni del sistema operativo chiamati “driver”.

Ogni periferica nuova che si collega al computer (stampanti, unità di memoria

di massa, schede...) richiede che venga installato il proprio driver nel

sistema operativo e non necessita più modifiche alla ROM.

In alcuni personal, da scrivania o portatili, vengono inserite memorie ROM

speciali, contenenti parti del sistema operativo come firmware. Queste ROM

vengono chiamate Flash-ROM o Boot-ROM, perché consentono di avviare il

computer e di trovarsi pronti al lavoro in pochi secondi.

Essendo, però, a sola lettura, queste memorie non consentono di aggiornare il

sistema operativo, se non con la sostituzione delle ROM stesse, sempre che il

produttore abbia mantenuto quel particolare modello di personal ancora in

produzione.

In altri computer, ad esempio i notebook, nelle ROM non solo è stato inserito

il sistema operativo, ma anche alcuni programmi applicativi: un word processor,

un foglio di calcolo, un programma di agenda e appuntamenti ed uno per la

gestione di una base di dati. Ciò consente di eliminare il lettore dei

floppy, il lettore di CD-ROM e parte del disco rigido, alleggerendolo in peso

ed in costi, ma vincola per sempre a non cambiare programma ed a non poter

fare aggiornamenti.

Il lato positivo dell’avere i programmi permanenti in ROM è di poterli

richiamare in una frazione di secondo e nel poter saltare dall’uno

all’altro con un semplice tasto. In alcuni notebook è possibile spengere il

computer avendo sullo schermo un lavoro e, nel riaccenderlo, trovare lo stesso

lavoro allo stesso punto in cui l’avevamo lasciato. Inoltre, eseguire un

programma prelevandolo dalla memoria ROM comporta per il computer un dispendio

di energia molto inferiore di quello che sopporterebbe se dovesse eseguirlo da

un disco rigido.

Questa memoria viene chiamata RAM, dall’inglese Random Access Memory, cioè

“memoria ad accesso casuale”. Il che non vuol dire che il computer carica

programmi e dati “dove capita, capita”, ma sottintende una procedura molto

più complessa di quella che il nome lascia intendere.

Se diamo ad un computer il comando di eseguire un determinato programma,

questo viene letto dal disco e caricato nella memoria RAM. La proprietà

“casuale” della memoria RAM viene fuori quando inizia l’esecuzione del

programma.

Tutti i programmi sono composti da vari spezzoni, ognuno dedicato ad

un’attività diversa. Ci sarà uno spezzone per la visualizzazione su

schermo, un altro per l’elaborazione del testo, altri ancora per

l’effettuazione di calcoli o la creazione di grafici. Ogni spezzone è stato

caricato in memoria l’uno dopo l’altro senza suddivisione, ma in una parte

apposita del programma sono “dichiarate” le lunghezze dei vari spezzoni.

Quando si verifica il bisogno di uno spezzone, il computer non è costretto a

leggersi tutto il programma dall’inizio alla fine. Sapendo dove inizia il

programma e la lunghezza dei vari spezzoni, è semplice andare direttamente a

leggere nel punto giusto. Né conta se quel programma è stato registrato in

una parte od in un’altra della memoria. “Casuale”, in questo caso, è

contrapposto a “sequenziale” e vuol dire semplicemente che si può andare

a leggere una qualsiasi posizione di memoria.

Non soltanto la memoria RAM è vuota quando acquistiamo il computer, ma anche

tutte le volte che lo accendiamo. In essa, infatti, non è possibile

conservare permanentemente un programma. La RAM è “volatile”: ha bisogno

continuamente della corrente elettrica che alimenta il computer, altrimenti

perde il suo contenuto.

Del resto i programmi che utilizziamo sul nostro computer sono molti: se

ognuno di essi venisse tenuto per sempre in memoria, ben presto dovremo

iniziare ad aumentare incessantemente i chip di memoria per poter ancora

lavorare. Quindi, molto semplicemente, quando spengiamo il nostro computer,

tutto quello che è stato caricato nella memoria RAM viene cancellato.

Riguardo ai programmi, nessun problema. Essi sono registrati sul disco rigido

e, volendo di nuovo lavorare con quel programma, basta chiederne

l’esecuzione ed il sistema operativo provvede a caricarlo in memoria RAM. Il

problema sorge per i documenti. Se abbiamo creato un documento nuovo, o

modificato uno già esistente, il documento si trova ancora in memoria RAM.

Spengere il computer in questo momento provoca la cancellazione della memoria

RAM e quindi la perdita di tutto il lavoro che non abbiamo provveduto a

registrare sul disco rigido.

Lo spegnimento del computer potrebbe anche non essere volontario: il contatore

che salta, un blackout della corrente, un collega che inciampa nel cavo e

stacca la spina, sono incidenti probabilissimi che causerebbero la perdita di

tutto il lavoro in corso e non ancora registrato. E’ buona regola registrare

frequentemente su disco rigido il lavoro che si sta facendo, oppure subito

dopo operazioni importanti di modifica.

La dimensione della memoria RAM è un elemento molto importante nella

configurazione di un computer, seconda solo alle caratteristiche del

microprocessore. Più RAM abbiamo nel computer, più questo potrà lavorare

con programmi complessi ed elaborare un maggior numero di dati.

Se la memoria RAM non basta a contenere un programma, questo non può essere

eseguito. Se il programma entra nella memoria, ma il documento sul quale

vogliamo lavorare non può essere caricato nella parte libera rimasta, il

sistema operativo è costretto ad effettuare continue operazioni di

registrazione e di lettura del documento.

Il sistema operativo carica in memoria solo una parte di documento e, quando

chiediamo di andare avanti nel lavoro, la registra sul disco per poter leggere

e caricare in memoria la porzione successiva. Uguale impegno viene richiesto

da programmi particolarmente complessi che sono stati frazionati in un certo

numero di file. Il sistema operativo, di volta in volta, carica dal disco

quello richiesto. Questo tipo di frazionamento è molto diffuso, perché

facilità la compatibilità verso macchine con memoria inferiore a quella

teoricamente necessaria.

La quantità minima di memoria RAM per un computer era unanimemente

riconosciuta in 512Kb fino a quando esistevano i sistemi operativi di tipo

testo (DOS). Al di sotto di quella dimensione era difficile che qualche

programma riuscisse a funzionare.

Oggi, che si lavora con applicazioni molto più complesse, con un numero di

dati consistente, con sistemi operativi che fanno uso della grafica e del

colore, la memoria RAM richiesta inizia a salire da un minimo di 4Mb, fino a

8Mb ed a 16Mb per lavoro ordinario, spingendosi a 32Mb, 64Mb e molto oltre per

programmi che elaborino immagini o suoni.

Queste cifre (4, 8, 16, 32 e 64) fanno subito capire come la memoria RAM

spesso si aumenti raddoppiando. La RAM di un computer, infatti, la si può

aumentare ogni qual volta se ne abbia bisogno.

La quantità di memoria RAM presente nella configurazione base di un computer

viene sempre indicata dal produttore. Se non è adeguata per l’utilizzo che

se ne vuole fare, è bene chiedere l’aumento alla quantità necessaria sin

dal momento dell’acquisto della macchina.

E’ comunque possibile incrementare la quantità di memoria RAM anche in

seguito. La scheda madre possiede appositi connettori nei quali è possibile

inserire i chip aggiuntivi. La memoria RAM viene venduta in piccoli moduli,

grandi quanto una barretta di cioccolato. Si chiamano SIMM, dall’inglese

Single Inline Memory Module.

Esistono SIMM da 4, 8, 16Mb e così via. I costi di questi moduli di

espansione della RAM, grazie anche all’aumento della richiesta e della

produzione, sono calati enormemente nel corso degli ultimi anni.

Poiché i connettori presenti nella scheda madre per inserire le SIMM sono

pochi, spesso quattro, conviene affrontare la spesa una volte per tutte e

comprare più memoria di quella strettamente indispensabile, perché futuri

incrementi di RAM saranno impossibili senza dover togliere le SIMM presenti.

Se abbiamo quattro connettori occupati da quattro SIMM da 4Mb ciascuna, per un

totale di 16Mb, e vogliamo aumentare la RAM di altri 16Mb, non sarà possibile

acquistare solamente i 16Mb in più. Dovremo togliere le quattro SIMM e

buttarle in un cassetto ed acquistare quattro SIMM nuove da 8Mb ciascuna per

metterle al loro posto.

Saremmo stati più previdenti se avessimo fatto l’incremento precedente

direttamente a 32Mb, oppure se avessimo acquistato due SIMM da 8Mb.

Esistono differenze fisiche fra le varie SIMM, come la lunghezza, la

larghezza, lo spessore e il numero dei “piedini”. Esistono differenze

elettroniche, per la presenza di chip con determinate caratteristiche.

I moduli si distinguono, oltre che per la capacità, anche per la velocità.

Il manuale indicherà, ad esempio, di usare esclusivamente moduli con velocità

minima di 60 nanosecondi. La velocità è il tempo che occorre allo scambio

dei dati con il computer: più la cifra è bassa, più il traffico può essere

veloce.

Si parla di velocità minima perché una memoria RAM più veloce è

installabile al posto di una più lenta, ma non viceversa. Si può installare

un modulo di chip a 60 nanosecondi al posto di uno a 80 nanosecondi, ma non il

contrario.

Il numero di connettori interni per contenere le SIMM è ridotto, spesso uno

solo, mentre il costo delle SIMM per portatili è di sicuro maggiore rispetto

alle SIMM normali. Ed inoltre bisogna fare ancor più attenzione alla

corrispondenza delle caratteristiche.

Un personal con 80486 e Windows 3.11 funziona perfettamente con 2Mb di memoria

RAM, quando ha in esecuzione semplici programmi di videoscrittura. La quantità

minima necessaria passa a 4Mb se si vuole utilizzare un foglio di calcolo ed a

8Mb se si tratta di realizzare il bollettino aziendale od un volantino

pubblicitario.

Un personal con processore Pentium e Windows 95, con il quale vogliamo

lavorare in videoscrittura richiede almeno 8Mb, per passare a 16Mb per

utilizzare anche un foglio di calcolo.

In un computer la RAM non è mai abbastanza e, situazione finanziaria

permettendo, è sempre meglio abbondare che mancare. E’ opportuno consultare

prima il manuale e le caratteristiche tecniche del software che dovremo

utilizzare e considerare che spesso ci troveremo nella situazione di lavorare

contemporaneamente con più programmi.

Le prestazioni: capacità e velocità

Non bisogna confondere la “capacità” di un computer con la sua “velocità”.

La quantità di memoria RAM presente determina la sua capacità, cioè la

quantità di dati che può elaborare, e non la sua velocità.

Una espansione della RAM ci può consentire, ad esempio, di lavorare con più

software contemporaneamente (un foglio di calcolo ed un word processor) perché

espande la capacità del computer. La velocità ne è influenzata solo

indirettamente: avendo i due software già caricati è possibile passare

dall’uno all’altro in un istante senza dover attendere la chiusura del

primo ed il caricamento del secondo. La velocità di lavoro nel singolo

software, invece, non è minimamente incrementata.

Avendo una RAM già abbastanza capace di contenere più software con i

relativi documenti, espandere ulteriormente la RAM non aumenta la velocità

del computer in nessun modo.

La velocità di un computer è determinata dal clock, cioè dalla frequenza

del processore. Nelle ultime generazioni di computer è possibile sostituire

il processore con uno delle stesso tipo (Pentium con Pentium) ma più velode

(da 133 MHz a 200 MHz, ad esempio).

Dovendo utilizzare più di un programma contemporaneamente, può darsi che la

somma della memoria RAM richiesta dai programmi superi la capacità della

memoria RAM installata. In questo caso è possibile simulare la presenza di

una quantità superiore, anche doppia o tripla, di RAM. Questa memoria

“inesistente” viene chiamata “memoria virtuale”.

Per la creazione della memoria virtuale ci si può servire del sistema

operativo (Windows ‘9x e Macintosh 7.x) o di appositi programmi d’utilità.

Il metodo di creazione della memoria virtuale è, nei due casi, diverso.

Il sistema operativo utilizza principalmente il disco rigido. Quando abbiamo

uno o più programmi in memoria RAM e ne vogliamo caricare un altro, e la

somma della memoria richiesta dai programmi supererebbe la RAM fisicamente

disponibile, il sistema operativo registra su disco rigido i programmi non

attivi (compresi gli eventuali documenti aperti con quei programmi) e

quant’altro sia possibile scaricare temporaneamente dalla RAM, per lasciare

posto al nuovo programma. Quando chiederemo di tornare a lavorare con uno dei

programmi precedenti, il sistema operativo scaricherà su disco il programma

diventato inattivo (compresi i documenti aperti) e caricherà nella RAM il

programma richiesto.

Con questo metodo possiamo utilizzare più RAM di quella fisicamente presente

nel personal. Dovremo però pagare due pedaggi: meno spazio disponibile su

disco e velocità ridotta di lavoro.

Sul disco rigido, infatti, viene creato un file invisibile di sistema pari

alla dimensione complessiva della memoria virtuale. Se abbiamo installato RAM

per 8Mb e, grazie alla memoria virtuale, vogliamo fingere di averne 16Mb, il

sistema operativo deve creare un file di 16Mb su disco, riducendo lo spazio a

disposizione per registrare documenti e software. D’altra parte, tutte le

volte che passeremo da un programma all’altro fra quelli mandati in

esecuzione, dovremo aspettare che il sistema operativo scarichi dalla RAM il

programma non più attivo e carichi il programma al quale abbiamo chiesto di

passare.

I programmi, inoltre, occupano sempre meno spazio di quello che richiedono. Un

programma che chiede 4Mb di RAM, ad esempio, in effetti ne occupa anche la

sola metà, in situazione di inattività. L’utilità, da una parte

comprimendo il programma, dall’altra recuperando lo spazio non utilizzato,

riesce a “ricavare” abbastanza memoria da ospitare altri programmi.

Solamente a questo punto, se lo spazio ancora non basta, ricorre alla

registrazione su disco. Si tratta, però, della registrazione di dati

compattati, e quindi le operazioni di scrittura/lettura sono molto più veloci

di quelle richieste dal sistema operativo.

Il file creato dal programma di utilità è a grandezza dinamica, cioè non

occupa uno spazio su disco pari al totale della memoria virtuale, bensì

occupa uno spazio variabile a seconda della necessità.

Abbiamo visto come il sistema operativo si incarichi di leggere dal disco i

vari file in cui è frazionato un programma o, ad esempio, le varie parti di

un grosso database. Se è presente una scheda di memoria cache, il sistema

operativo carica i file letti dal disco sia nella memoria RAM che nella

memoria cache.

Ad una nuova richiesta di caricamento di un file, il sistema operativo esamina

il contenuto della scheda cache e solo se non vi trova il file richiesto ne

effettua la lettura da disco. Se quella frazione di programma o documento era

stata recentemente utilizzata, è già presente nella cache e quindi il

sistema operativo ne effettua il caricamento senza alcuna lettura da disco.

Essendo il caricamento da memoria cache di gran lunga più veloce di quello da

disco, ne deriva la conseguenza che la presenza di una scheda di memoria cache

velocizza le operazioni.

In alternativa, è possibile creare una memoria cache virtuale tramite

appositi programmi di utilità. In questo caso la memoria cache virtuale usa

parte della normale RAM.

Solitamente l'hard disk viene indicato anche con i seguenti termini: memoria

di massa, memoria secondaria, disco fisso.

![]()

Vediamo come si ottengono i colori nei monitor e similmente nei display LCD:

Tutti i monitor funzionano essenzialmente sfruttando le stesse impiegate per i

comuni televisori. L’immagine sullo schermo viene costruita mediante un «pennello»

elettronico che, spazzolando la superficie interna del vetro, eccita i fosfori

che la ricoprono. I fosfori - rossi, verdi e blu disposti alternatamente secondo

lo schema RGB - reagiscono a questa sollecitazione elettronica illuminandosi. Il

fascio elettronico, (il raggio catodico) viene prodotto da un cannone posto sul

fondo del tubo. La prima, fondamentale differenza tra le varie tecnologie è

proprio il cannone elettronico.

Fosforo e immagini

Il CRT Trinitron è un tipo di CRT a colori in cui il fosforo è riportato sulla

superficie interna del tubo lungo strisce verticali (anziché, in punti, come

nei CRT a colori standard). Il pennello elettronico passa attraverso un griglia

di apertura anziché, attraverso una maschera I monitor basati su CRT Trinitron

hanno immagini più brillanti, contrasto più netto e messa a fuoco migliore

rispetto ai monitor CRT standard, in quanto la griglia di apertura non ostacola

il passaggio della luce come maschera e il pannello di elettroni può essere il

meglio controllato. I CRT FlatScreen hanno una superficie con raggio di

curvatura più elevato, apparendo così più piatti rispetto alla maggior parte

dei CRT tradizionale. Il CRT di tipo FS riduce il riverbero e i riflessi e

aumenta la superficie disponibile per l’immagine. Adottata per in esclusiva da

un solo produttore, la tecnologia CromaClear combina diverse caratteristiche

degli altri tipi di schermi CRT. I sistemi che si basano su questa soluzione,

hanno un passo orizzontale di 0,255 mm, il mask pitch di 0,25 mm e grazie al

focus dinamico consentono la correzione sui punti dello schermo evitando la

distorsione ellittica.

Il fattore «maschera»

Un’altra differenza fondamentale è data dal tipo di maschera, posta dietro lo

strato dei fosfori. La maschera dei monitor Trinitron è detta Aperture Grille

ed è composta principalmente da una cornice metallica vuota sui cui i bordi

sono tesi in posizione verticale dei filamenti esternamente sottili; poichÈ

questi filamenti sono separati l’uno dall’altro da una distanza minima (0,26

mm per gli schermi a 17 pollici), vengono applicati altri due filamenti

orizzontali che mantengono il perfetto allineamento verticale della griglia.

La schermata dei monitor convenzionali è denominata Shadow Mask ed è formata

da una sottilissima superficie metallica ricoperta da minuscoli fori posti a

distanza molto ravvicinata.

In entrambi i casi parlando di distanze minime, ma, comunque, nei monitor

Trinitron, la distanza tra un filamento e l’altro è tale da lasciar passare i

tre raggi, così come, nei monitor convenzionali e in quelli a schermo piatto,

il diametro di un foro e sufficientemente largo da permettere il passaggio del

fascio RGB.

Quando il monitor è acceso, la maschera può raggiungere i 60 gradi centigradi.

Questo calore provoca un’espansione nel metallo che la compone, di conseguenza

la maschera subisce delle distorsioni che influenzano negativamente la purezza

dei colori: è questo il motivo principale per cui, nei monitor tradizionali, la

maschera ha una forma convessa; questa forma infatti attenua l’effetto di «doming»

provocato dall’espansione termica. I nuovi monitor «flat» montano delle

maschere fatte di Invar, un materiale a bassa espansione termica, che

praticamente non subisce modifiche al variare della temperatura e che, quindi,

ha permesso un migliore controllo della purezza del colore e l’abbandono della

tradizionale forma convessa. Nei monitor Trinitron, invece, questo effetto di

doming non si verifica perchÈ i filamenti della griglia di apertura sono in

tensione tra le due sbarrette orizzontali e la cornice di supporto.

D’altra parte le due strisce orizzontali sono leggermente visibili e questo, a

distanze ravvicinate o su sfondi chiari, può provocare un po’ di fastidio.

Abbiamo già visto che, nei monitor tradizionali e a schermo piatto, i fosfori

sono dei puntini rotondi disposti a trifoglio», ogni triade è composta da un

fosforo rosso, uno blu e uno verde. Nei monitor Trinitron, invece, i fosfori

sono delle strisce continue verticali.Quando bisogna riprodurre sullo schermo

delle linee sottili, come nelle applicazioni CAD, questo secondo sistema risulta

molto più preciso, le linee infatti sono realmente continue, mentre nei monitor

Shadow Mask le linee sottili vengono visualizzate con un tipico effetto «a onda»,

causato dalla disposizione dei fosfori e dalla forma della maschera.

Questo effetto può essere ridotto diminuendo la distanza tra i fori sulla

maschera, ma non può essere completamente rimosso.

Il fascio di raggi catodici dal cannone elettronico può subire delle piccole

deviazioni causate dai campi magnetici esterni ed in particolar modo da quello

terrestre. Il tubo Trinitron è particolarmente sensibile al Nord e al Sud

magnetici, sensibilità che può influire sulla convergenza statica

dell’immagine.

Questo inconveniente, nel caso dovesse verificarsi, può essere ovviato da una

regolazione «fine» dopo l’installazione del monitor stesso.

Al contrario i monitor convenzionali e a schermo piatto non soffrono di questa

sensibilità, causata nei Trinitron dalle caratteristiche di costruzione

dell’unico cannone a tre raggi.

E’ più restrittiva delle normative precedenti quella emessa dall’ente

Swedish Confederation of Professional Employees e pubblicata lo scorso luglio.

L’introduzione del TCO ‘99 è mirata a incrementare la qualità e le

performance di personal computer, portatili e unità dispaly, sia Crt sia Flat,

con l’estensione a tastiere e unità di sistema. Le innovazioni introdotte dal

TCO ‘99 sono riassumibili nelle «quattro E»: Ecologia, Ergonomia, Energia ed

Emissioni. Le regole prendono in considerazione il rapporto tra utente macchina

nel rispetto delle regole di qualità.

I 4 punti del TCO ‘99

Parametri più restrittivi sono applicati all’ergonomia che comprende

richieste più restrittive per la luminescenza, l’uniformità dell’immagine,

il contrasto, il flickering e il riflesso. Sono inoltre introdotti limiti per

l’emissione di rumore. La norma prende in considerazione anche il design delle

tastiere.

Per quanto riguarda il consumo di energia, è previsto un livello di consumo in

stand by più basso, con una velocità di riavvio di tre secondi. I valori delle

emissioni rimangono uguali a quelli previsti da TCO ‘95, ma le misurazioni

saranno condotte in maniera più restrittiva. I criteri ecologici di prodotto

sono sostanzialmente gli stessi, è previsto l’uso da parte della società

produttrice di materiali a basso impatto ambientale e una collaborazione più

stretta con i fornitori di parti elettroniche e con le società che si occupano

di riciclaggio.

Alcuni suggerimenti

- Collegate sempre il vostro monitor a una presa a terra. Se usate una presa a 2

poli senza messa a terra, il campo elettrico a bassa frequenza può essere fino

a 10 volte più intenso.

- Fate in modo che il monitor appena acquistato resti acceso per alcuni giorni

in un ambiente ventilato prima di usarlo. Questo farà in modo che le sostanze

chimiche provenienti dal processo produttivo, vengano smaltite. Dopo una

settimana circa, esse si saranno ridotte del 10 % rispetto alla quantità

iniziale.

- Ricordate che la qualità dell’immagine dipende anche dal sistema grafico

del vostro Pc, il quale determina sia la risoluzione che la frequenza di refresh.

Per ottenere un’immagine che non lampeggi (flicker-free) è necessario che la

frequenza di refresh sia almeno di 80 Hz o maggiore. Una scheda grafica di buona

qualità fornisce un’immagine nitida.

- Con l’invecchiamento del monitor, si può notare una riduzione della

luminosità e anche il fuoco può deteriorarsi. Un buon monitor dura almeno 5

anni. Ogni anno è consigliato un controllo da parte di un tecnico.

Molto spesso è utile introdurre informazioni grafiche nel computer, come

digitalizzare una fotografia, un grafico od un testo.

Questo compito è svolto da una apparecchiatura chiamata scanner. Le foto ed i

disegni ripresi dallo scanner, convertiti in dati digitali e registrati su

disco, possono essere stampati, rielaborati e modificati a piacere.

Esistono programmi per il ritocco fotografico e per il disegno, attraverso i

quali è possibile importare l’immagine digitalizzata con lo scanner ed

effettuarne tutte le modifiche necessarie. La potenza di questi programmi

consente di alterare le fotografie e di produrne di completamente false, così

come di inserire frammenti di queste nei disegni e viceversa. Si può tagliare

un’immagine, ingrandirla o ridurla, ribaltarla, ruotarla, correggere

l’esposizione, correggere la mesa a fuoco, correggere il contrasto o la

luminosità, sostituire i colori o produrre particolari effetti di rilievo,

sfaccettatura, vento, mosaico...

Lo scanner ha largo impiego nel campo della grafica computerizzata, alla quale

serve anche come modello di “ricalco” o come base per realizzare

illustrazioni, marchi o logotipi. Nel campo dell’editoria, sia aziendale che

commerciale, e della pubblicità, lo scanner serve per inserire direttamente

le foto nei bozzetti, evitando costose e lente lavorazioni presso laboratori

specializzati.

Lo scanner è anche utili con un particolare tipo di applicazione, chiamato

riconoscimento ottico di caratteri (OCR), che prevede l’interpretazione di

normali fogli dattiloscritti ricavandone il testo scritto, così come se fosse

stato digitato direttamente sul computer, con percentuali di errori minime in

caso di originali di buona qualità. Questa applicazione è particolarmente

utile per evitare la ribattitura di testi già esistenti stampati o

dattiloscritti, che basta “passare” nello scanner.

I programmi di riconoscimento ottico dei caratteri sono però molto sensibili

alla qualità degli originali. Testi in fotocopia sbiadita oppure con stampa

difettosa, vengono interpretati con moltissimi errori, tanti da renderne

inutile l’interpretazione.

Una delle ultime novità tecnologiche sono le fotocamere digitali. Queste

macchine fotografiche, esternamente identiche a quelle tradizionali,

effettuano direttamente la digitalizzazione dell’immagine senza bisogno del

passaggio su carta fotografica, perché poi l’immagine, trasferita via cavo

al computer, possa avere tutte le elaborazioni possibili nei programmi di

ritocco fotografico di cui si è parlato più sopra.

Gli scanner

Dal punto di vista meccanico, gli scanner si possono dividere in:

• scanner a rullo;

• scanner a tamburo;

• scanner per pellicola;

• scanner su stativo;

• scanner manuali.

Uno scanner a ripresa in piano è costituito, in pratica, dalla parte

superiore di una fotocopiatrice. I fogli vengono poggiati su un ripiano in

vetro, al di sotto del quale scorre una forte luce, uno specchio ed un

obiettivo. All’inizio della ripresa il gruppo ottico, formato da luce,

specchio ed obiettivo, si sposta effettuando una ripresa di tutto il foglio.

Il ripiano, con il foglio, rimane fermo.

A differenza della fotocopiatrice, le immagini non vengono inviate ad un rullo

di stampa, ma al computer attraverso la porta seriale. Un programma trasforma

i segnali in immagini digitalizzate, che vengono registrate sul disco. Questo

software è il programma “pilota” dello scanner e quasi mai consente di

modificare le immagini se non per la luminosità, il contrasto, il taglio

della ripresa ed il bilanciamento dei colori.

Molti scanner a ripresa in piano hanno la possibilità di montare uno speciale

coperchio per la ripresa dei film fotografici, diapositive o negativi, che

contiene una forte fonte di luce. La qualità della ripresa è inferiore a

quella ottenuta con gli scanner per pellicola

Alcuni hanno anche la possibilità di montare al posto del coperchio, un

meccanismo di trascinamento con il quale è possibile scannerizzare una serie

di fotografie o fogli singoli.

Questo è il tipo di scanner più diffuso. Inizialmente aveva una qualità

inferiore di quelli a tamburo, adesso non ha nulla da invidiare agli scanner

professionali, né in risoluzione, né in fedeltà, né in velocità.

E’ possibile acquisire immagini anche da pagine di libri, oggetti piccoli

come biglietti da visita, ritagli irregolari, fogli sottili (se ci sono

problemi di trasparenza, cioè si intravede anche l’immagine presente sul

retro del foglio scannerizzato, è meglio frapporre un foglio nero fra

coperchio e foglio) e persino piccoli oggetti come orologi, penne, una mano...

l’unica precauzione è quella di tenere sempre il vetro accuratamente

pulito.

Lo scanner a trascinamento è privo del ripiano in vetro. Le fotografie od i

fogli passano attraverso un apposito inseritore e vengono trascinate sopra al

gruppo di ripresa, uscendo dalla parte opposta della macchina.

E’ più adatto per la scansione di fogli che di fotografie, in quanto

queste, con la superficie lucide e su carta fotografica rigida, spesso

scivolano e si incastrano nel meccanismo di trascinamento. Stesso discorso per

fogli troppo sottili, che si inceppano o si rompono.

Un altro problema di questi scanner è che non accettano ritagli di fogli od

oggetti di piccole dimensioni (come biglietti da visita) e che non è

possibile riprodurre immagini da libri.

Sono diffusi soprattutto come scanner economico per l’acquisizione di

documenti (lettere) a fogli singoli sia per l’archiviazione digitale che per

l’OCR. Sono più economici degli scanner a ripresa in piano, in quanto non

hanno il complesso sistema di spostamento del gruppo ottico.

ALcuni modelli permettono di staccare il gruppo ottico, che così può essere

utilizzato, come fosse uno scanner manuale, per leggere originali più grandi

o per acquisire da pagine di libro.

Lo scanner a tamburo è composto, invece, da un gruppo ottico fisso e da un

cilindro, o tamburo, sul quale si fissa la fotografia. Chiuso lo scanner, il

tamburo inizia a ruotare velocemente facendo passare la fotografia sul gruppo

ottico.

Per la loro fedeltà, risoluzione e velocità, sono sempre stati utilizzati

nei laboratori professionali di fotocromia. Sono, infatti, gli eredi dei

giganteschi scanner specializzati utilizzati dai fotocromisti per le selezioni

da stampa.

Fra i tipi di scanner, sono i più costosi. Ormai sono stati soppiantati dagli

scanner a ripresa in piano.

Scanner per pellicola

Lo scanner per pellicola può digitalizzare esclusivamente fotografie su

diapositive o negativi fotografici, di vari formati. La luce illumina il film

da un verso, mentre dalla parte opposta un obiettivo ne riprende l’immagine.

Non accetta, ovviamente, supporti opachi come fogli di carta.

Nonostante alcuni scanner a ripresa in piano siano dotati di un coperchio per

i film, gli scanner per pellicola sono sempre indispensabili per ricavare

riproduzioni di qualità. Essendo apparecchiature più precise, più complesse

e meno diffuse, sono anche più costose.

Lo scanner su stativo presenta un ripiano sul quale vengono poste le

fotografie, fissate ad appositi rifermi per impedire che si muovano. Di lato

sono presenti due o quattro forti lampade, mentre dall’alto, ad una altezza

modificabile, un obiettivo riprende l’immagine.

Lo scanner su stativo ha invece la possibilità di effettuare direttamente

delle vere e proprie fotografie, potendo poggiare sul ripiano oggetti di

qualsiasi dimensione. D’altra parte la digitalizzazione di fotografie o

fogli singoli presenta difficoltà: l’originale si può spostare, si può

incurvare, è soggetto al deposito di sporchi e polvere che verrebbero ripresi

con la foto compromettendone l’immagine.

Le macchine fotografiche digitali li hanno completamente sostituiti.

Lo scanner manuale ha un gruppo di ripresa molto contenuto, di larghezza

limitata, in una impugnatura che è facilmente spostabile sulla fotografia,

dall’alto verso il basso. Mentre si trascina lo scanner sulla foto, il

gruppo di ripresa passa davanti all’immagine.

Lo scanner manuale è senz’altro il modello più economico. Il piccolo

gruppo di ripresa, una diecina di centimetri, costringe però a passare più

volte sulla stessa foto se questa ha una larghezza maggiore dello scanner. Ne

conseguono alcuni problemi per “sincronizzare” le diverse porzioni

dell’immagine affinché non ci si accorga che è stata scannerizzata “a

pezzi”.

Questo tipo di scanner ha avuto un momento di popolarità quando i prezzi

degli scanner a ripresa in piano erano proibitivi, soprattutto quelli a

colori. Questi apparecchi rappresentavano una alternativa “casalinga”, per

chi avesse poche pretese di qualità o pochi soldi da spendere. Ades so che i

prezzi si sono abbassati, il loro mercato si è ristretto.

Fino a pochi anni fa, gli scanner erano lentissimi, molto costosi, capaci di

riprendere solamente in bianco e nero (al massimo 256 tonalità di grigio).

L’uso era complesso e, per immagini da pubblicare su giornali o riviste, era

sempre meglio ricorrere ai laboratori di fotocromia. In pratica si potevano

utilizzare solamente per riprendere testo o immagini grafiche semplici e

monocromatiche.

Gli scanner a colori erano ancora più costosi e lenti. Davano buoni risultati

solamente con immagini in bianco e nero e pessimi con quelle a colori. Un uso

professionale era impensabile.

In pochi anni gli scanner sono diventati un’apparecchiatura dalle

prestazioni prima inimmaginabili. A prezzi del tutto abbordabili.

Le caratteristiche tecniche principali sono:

• risoluzione in output: l’immagine ripresa otticamente viene

elaborata (interpolazione) dal software di ripresa e la risoluzione viene

incrementata fino a 1200, 2400, 4800 dpi ed oltre;

• colore: capacità di riconoscere le diverse sfumature di colore, o

meglio, i diversi colori. Un buon scanner dovrebbe riconoscere 16,7 milioni di

colori (sensibilità maggiore di quella dell’occhio umano) con 24 bit per

pixel. Gli scanner professionali per fotolito arrivano a riconoscere oltre un

miliardo di colori a 36 bit per pixel. Con immagini in bianco e nero sono

sufficienti 256 livelli di grigio con 8 bit per pixel;

• velocità: è espressa in millisecondi (msec) per linea;

• elaborazione dell’immagine: deve essere possibile modificare il

valore gamma (è la misura del contrasto che determina i mezzitoni di

un’immagine), la correzione del colore a seconda del tipo di monitor su cui

si visualizza l’immagine o della stampante di destinazione, la nitidezza, il

contrasto e la luminosità;

• interfaccia: dovrebbe essere presente sia l’interfaccia RS-232

che quella SCSI;

• formato: è il formato standard dei fogli o delle pellicole che è

possibile acquisire. Per i fogli, la maggioranza degli scanner è di formato

A4 (21x29,7 cm), mentre alcuni scanner professionali sono più grandi ed

arrivano al formato A3 (29,7x42). Per le pellicole il formato più comune è

il 35 mm (24x36 mm) in striscia mentre i formati professionali devono

prevedere un apposito telaietto;

• area di lettura: rappresenta le dimensioni massime dell’area che

è possibile acquisire, che spesso non coincide con il formato;

• driver: deve essere presente un dischetto con i driver per tutti i

sistemi operativi (DOS, Windows, Windows ‘95/97/98, Windows NT, Maintosh).

Gli scanner migliori hanno un driver di tipo TWAIN, il che consente di

effettuare l’acquisizione dell’immagine direttamente dal programma di

grafica, di OCR, di DTP, di trasmissione fax, di elaborazione fotografica o di

archiviazione dei documenti, senza la necessità di usare il software

specializzato;

• software: deve essere fornito almeno un programma specializzato di

acquisizione, oltre ad eventuali programmi (in versione di prova) per

l’elaborazione fotografica o l’OCR;

• affidabilità: è la durata teorica dello scanner, almeno 100 mila

scannerizzazioni negli scanner a ripresa in piano e almeno qualche diecina di

migliaia in quelli per pellicola.

Il processo di acquisizione avviene in due tempi.

Prima si effettua un’anteprima dell’immagine, a bassa risoluzione e quindi

veloce. Il software specializzato o il driver TWAIN mostrano una riduzione

dell’immagine, sulla quale si può intervenire per effettuare tagli

dell’immagine (cioè riprese parziali, se parti dell’immagine non

interessano) rettangolari o sagomati. Inoltre si può modificare il gamma,

correggere il colore, modificare contrasto e luminosità. Dopo aver scelto la

risoluzione desiderata e la quantità di colori (non sempre è necessario

utilizzare i valori massimi) e la proporzione dell’acquisizione (riducendo o

ingrandendo l’immagine), si da il via all’acquisizione vera e propria.

In questo secondo passaggio, più lento, il gruppo ottico effettua la

scannerizzazione dell’immagine con i parametri scelti. L’immagine

digitalizzata è quindi registrata sul disco rigido oppure inserita nel

programma TWAIN.

Nel caso di una fotografia, nella quale il soggetto è rappresentato da un

notevole numero di colori, la risoluzione è meno importante del numero di

colori o di grigi a disposizione. Anche se lo scanner ha una risoluzione

massima di 1200 punti per pollice, la fotografia può essere ripresa con una

risoluzione di 300 punti per pollice purché venga utilizzata l’intera gamma

dei colori o dei grigi a disposizione.

Nell’immagine fotografica è difficilmente distinguibile una

digitalizzazione a 300 punti da una a 600 punti. L’immagine è formata da

sfumature di colore, non da punti

Al contrario, in un disegno al tratto nel quale siano usate poche

sfumature di colore e prevalgano i segni precisi dei contorni e delle linee,

il numero di colori può essere abbassato, mentre deve essere utilizzata la

risoluzione massima per ottenere la massima precisione nelle linee. Questa

tendenza si esaspera nella ripresa di un disegno tecnico in solo bianco e

nero, nel quale il colore può essere ridotto ad uno solo.

La risoluzione da usare nella ripresa deve anche essere collegata al tipo di

stampa che se ne vuole trarre alla fine della elaborazione. Se l’immagine

dovrà essere semplicemente visualizzata sullo schermo del monitor, la

risoluzione deve essere di 72 dpi, cioé quella dei monitor. Se invece la

figura deve essere stampata, è meglio che la risoluzione sia uguale a quella

della stampante.

E’ inutile digitalizzare a 600 punti per pollice una fotografia che sarà

stampata con una risoluzione di 300 punti per pollice. Per riprendere una foto

a 600 punti invece che a 300, lo scanner impiega il doppio del tempo e

richiede una quantità enormemente maggiore di spazio sul disco.

All’atto dell’acquisizione, il programma di ripresa da la possibilità di

registrare l’immagine secondo diversi formati grafici. A questo punto è

necessario conoscere quali di questi formati sono compatibili con il programma

di grafica, DTP o di ritocco che intendiamo utilizzare.

I formati più utilizzati sono: TIFF per le immagini fotografiche (a meno che

non debbano essere scontornate) ed EPS per le immagini grafiche, illustrazioni

o fotografie da scontornare. Questi formati sono riconosciuti da tutti i

software grafici, DTP o di ritocco. Le immagini da inserire su pagine Internet

vanno invece registrate nei formati GIF o JPEG.

Il modem è una apparecchiatura che serve per mettere in contatto due computer

distanti fra di loro, tramite la linea telefonica analogica o digitale.

La parola modem deriva da una sintesi dei termini “modulatore” e

“demodulatore” ed esprime il suo funzionamento con le linee telefoniche

analogiche, per le quali è nato. Queste linee sono adatte alla trasmissione

di suoni, non di impulsi digitali.

I bit, quindi, non possono transitare così come sono, ma devono essere prima

trasformati in suoni, o meglio in “fischi” modulati. Questa è la prima

funzione del modem: ricevere i bit dal computer e trasmetterli come suoni.

La seconda funzione del modem è di compiere il procedimento inverso:

trasformare i suoni modulati, che arrivano dalla linea telefonica, in bit da

inviare al computer.

Con questa “traduzione simultanea” due computer possono scambiarsi dati

(bit) trasmettendosi “fischi”. E’ lo stesso procedimento utilizzato dai

fax, ed a tutti è capitato di comporre un numero telefonico e di sentirsi

rispondere da una serie di fischi acuti: è la “voce” di un fax che

risponde al telefono.

Utilizzando la stessa procedura di modulazione/demodulazione, modem e fax

possono quindi essere integrati in una stessa apparecchiatura, il modem/fax.

Il flusso di bit dei dati del primo computer esce dalla porta seriale ed

arriva al modem. Qui il circuito di modulazione provvedere a trasformare i bit

in frequenze sonore che possono essere inviate lungo le linee telefoniche.

Il secondo modem riceve le frequenze sonore e, con un circuito di

demodulazione, le trasforma in bit, inviandone il flusso alla porta seriale

del computer cui è collegato.

Con questo semplice passaggio, di modulazione di frequenze sonore alla

partenza e di demodulazione all’arrivo, è possibile connettere due computer

come se fossero a pochi centimetri di distanza. L’unica differenza sta nella

velocità di comunicazione.

Poiché la trasmissione di dati molto spesso coinvolge nazioni diverse, i

protocolli utilizzabili sono stati definiti da un organismo internazionale, il

Comitato Consultivo Internazionale per la Telegrafia e Telefonia. Il CCITT ha

stabilito numerosi standard, ed a questi si sono uniformati tutti i

costruttori di modem.

Negli Stati Uniti si usano standard diversi per la trasmissione dati, definiti

Bell, dalla ditta che li ha elaborati.

Ovviamente i due modem corrispondenti ai due capi della linea telefonica,

devono essere preimpostati con lo stesso protocollo, altrimenti la

trasmissione è impossibile.

Le linee telefoniche commutate sono le normali linee telefoniche. La

comunicazione si effettua tramite la selezione di un numero telefonico e l’instradamento

attraverso vari centraline su linee utilizzate contemporaneamente anche da

altri utenti per diverse collegamenti.

Le linee ISDN sono installazioni particolari con le quali il collegamento fra

i due punti, pur utilizzando spesso, almeno in parte, le normali attrezzature

telefoniche, è elaborato con particolari tecnologie che permettono una

trasmissione senza alcun errore e più veloce.

La differenza è sostanziale. Nel caso della linea commutata i due computer

lavorano isolati per la gran parte del loro tempo, salvo effettuare una

telefonata quando è necessario uno scambio di dati. La linea è però

soggetta a disturbi derivati dall’instradamento e dalla condivisione della

linea. Nel caso della linea ISDN scambio di dati è assente da disturbi.

Nell’uno e nell’altro dei casi è necessario un modem a ciascun capo della

linea, ma i modem per linea commutata sono del tutto diversi da quelli per

linea ISDN.

I dati devono risiedere nell’elaboratore centrale per poterne consentire

l’accesso da parte di qualunque agenzia si rechi il correntista per

incassare un assegno. D’altra parte è necessario che qualsiasi operazione

effettuata in una filiale venga immediatamente registrata nell’elaboratore

centrale perché le altre filiali, richiedendo la situazione del cliente per

l’incasso di un altro assegno, possano avere quella reale e non quella del

giorno prima.

Se ciò non avvenisse con una comunicazione continua e grazie ad una linea

dedicata, un cliente potrebbe prelevare più denaro di quanto ne abbia sul

conto, presentandosi in filiali diverse in momenti di poco successivi o con

complici in altre città.

Questo tipo di collegamento, con costi ingenti per la linea e per

apparecchiature modem dal prezzo elevato, è appannaggio quasi esclusivo di

grandi aziende. Inoltre si tratta del collegamento fra elaboratori di grandi o

medie dimensioni, raramente di personal computer.

- velocità massima secondo le nostre esigenze: 300, 1’200, 2’400,

4’800, 9’600, 12'200, 28'800, 36'600 baud (bit per secondo) ed oltre;

- protocolli: CCITT se si vuole comunicare esclusivamente con paesi europei,

Bell se anche con gli Stati Uniti;

- correzione d’errore: MNP4, che consente la ricezione dei dati esattamente

come sono stati trasmessi, eliminando ogni possibile bit modificato da

interferenze (non è presente nei modem più economici);

- compressione: MNP5, che invia i bit codificandoli in modo che lo scambio

effettivo di dati sia più veloce della velocità tecnica del collegamento

(non è presente nei modem più economici).

- capacità telefax: la tecnica di trasmissione dei telefax non è molto

distante da quella dei modem. Basta un piccolo circuito in più ed il modem è

in grado di trasmettere e ricevere telefax, collegandosi con le tradizionali

apparecchiature telefax.

- autoalimentazione, che ne permette l’uso in situazioni particolari.

Ciò è un grande risparmio, senza dubbio, ma il modem indipendente occupa

spazio sulla scrivania, va acceso e spento, ha bisogno di un alimentatore

adattatore di corrente a parte. Alcuni utenti trovano più conveniente

utilizzare i modem cosiddetti interni, i cui componenti sono stati assemblati

su una scheda da inserire in uno slot all’interno del computer.

Si ha il vantaggio di non dover accendere né spengere il modem, perché la

scheda si alimenta direttamente dal computer. Non c’è neanche bisogno del

trasformatore adattatore esterno.

L’altra faccia della medaglia è che, cambiando personal, non c’è la

garanzia che la scheda modem funzioni anche nel nuovo computer, rischiando di

dover ripetere l’acquisto.

Dopo aver elaborato il nostro documento su schermo come al solito, lo inviamo

in stampa al modem. In questo caso il modem/telefax finge, rispetto al

computer, di essere una stampante. Il testo, invece di essere stampato, viene

trasformato in frequenze sonore, simili a quelle utilizzate per la

trasmissione dati ma usando protocolli diversi. Inviato ad una apparecchiatura

telefax attraverso la linea telefonica, il fax risulta totalmente identico a

quello che sarebbe arrivato se il documento fosse stato stampato su carta e

quindi trasmesso con un telefax normale.

La ricezione non è molto diversa, salvo che in questo caso il modem demodula

le frequenze sonore emesse dall’apparecchiatura telefax e le trasforma in un

documento grafico. Purtroppo non è ancora possibile la trasformazione del

telefax in semplice testo, non solo leggibile ma anche elaborabile. Il fax

arrivato è invece una vera e propria fotografia, occupando anche un rilevante

spazio sul disco per la sua registrazione.

La gran parte dei modem/telefax prevede solo la trasmissione dei fax e non la

ricezione.

Grazie al software di gestione del modem si può inviare un fax a destinatari

multipli e ad orari differiti. Questo consente un notevole risparmio sia di

tempo che di costi.

Non è più necessario passare le ore all’apparecchiatura telefax per

inviare alcune diecine di fax, perché il modem/fax effettua l’operazione

autonomamente. Se trova un numero occupato od un fax staccato, continua a

provare ad intervalli prestabiliti. Alla fine notifica all’utente i fax

inviati e quelli che non è stato possibile inoltrare.

Poiché le tariffe teleselettive sono inferiori durante la notte, è un grande

vantaggio lasciare che il modem/telefax effettui le sue operazioni dopo le ore

22. E’ sufficiente mettere in lista di spedizione per quell’ora i diversi

fax da trasmettere, ed il mattino successivo troveremo sullo schermo la solita

lista dei fax inoltrati e di quelli che non è stato possibile spedire.

Oppure ci si collega ad un elaboratore di grandi dimensioni, per ricevere ed

utilizzare dati in suo possesso. Fra gli esempi più diffusi di elaboratori

cui si può accedere via modem per ricavare informazioni:

- Poligrafico dello Stato: rende disponibili i testi originali delle Leggi

dello stato e di tutti i decreti pubblicati sulla Gazzetta Ufficiale;

- Seat, società editrice delle Pagine Gialle Telefoniche: con l’equivalente

elettronico delle Pagine Gialle,;

- Ansa: l’intero archivio storico di tutte le notizie trasmesse ai giornali.

Esistono servizi telematici professionali, grazie ai quali una categoria di

esperti può scambiarsi notizie ed opinioni partecipando ad una continua

conferenza a livello mondiale. Indipendentemente dalla località nella quale

abitano o lavorano, ingegneri, medici, giornalisti, avvocati, ricercatori, ma

anche presentatori di varietà, skipper, piloti aeronautici o pompieri,

possono collegarsi con il loro computer e partecipare pubblicamente, oppure

inviarsi messaggi personali.

E’ possibile effettuare acquisti, via computer, presso le più grandi catene

di grandi magazzini statunitensi o presso piccoli artigiani delle Hawai.

Ottenere una dieta bilanciata o consigli sul controllo delle nascite, su come

smettere di fumare o di bere alcoolici.

Si possono comprare o vendere oggetti usati, biciclette, macchine

fotografiche, e qualsiasi altra cosa, fra privati. O trovare suggerimenti

sull’allevamento di pesci da acquario.

Non c’è limite alla quantità di informazioni alle quali si può accedere.

Utilizzando Itapac, collegarsi con l’elaboratore Cerved, che si trova a

Padova, non richiede la teleselezione da Milano. Si può trasmettere i dati al

centro Itapac di Milano, che si mette in contatto su una linea speciale con il

centro Itapac di Padova, il quale ci consente il collegamento con il Cerved.

Questo passaggio è totalmente trasparente per il transito dei dati, una volta

stabilito il contatto. Anzi, poiché si utilizza la linea telefonica solo in

piccola parte, e la linea utilizzata da Itapac è dedicata alla sola

trasmissione dati, il flusso dei bit subirà minori interferenze di un

collegamento telefonico diretto. Ciò fa risparmiare in modo consistente non

solo sull’ordinaria telefonata in teleselezione, ma anche

sull’installazione di una linea dedicata quando questa non sarebbe

utilizzata in continuazione.

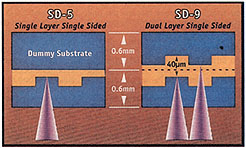

Un disco DVD può contenere un intero film con video di altissima qualità

(formato MPEG2) e audio stereofonico in più lingue differenti. Se usato come

supporto dati ha una capacità variabile da 4.7 a 17 GB, l'equivalente di circa

27 CD-ROM. La variabilità dipende dal fatto che un DVD è registrabile su

entrambe le facce. Inoltre, su ogni faccia sono presenti due livelli (strati)

registrabili separatamente, il primo dei quali semitrasparente. La capacità

massima si raggiunge quando sono utilizzati tutti e quattro gli strati

registrabili.

Segnala la definizione con cui lavora una macchina stampante.

Tutte le stampanti, con diversi sistemi, generano caratteri o disegni

utilizzando tanti piccolissimi punti messi assieme. Tali micro punti

possono essere colorati (di diverse sfumature), oppure possono assumere

le diverse gradazioni del grigio (se la stampante e' in B/N).Prorpio per

le considerazioni fatte sopra, possiamo dire che il DPI puo' essere

utilizzato come un buon termine di confronto nella valutazione di due

stampanti; infatti quella con DPI maggiore sara' la piu'

"pregiata", cioe' la piu' precisa, quella con maggior

definizione dei caratteri.

Ecco perche' a volte sono chiamate anche termiche

Per questo possono essere una valida alternativa alle stampanti laser,

naturalmente nei confronti di queste ultime perdono un po' in prestazioni,

soprattutto per quanto riguarda l'aspetto velocita' di stampa e nella

definizione (specialmente nell'uso del colore).

a seconda del tipo di macchina avremo allora un'unica cartuccia con toner

nero, oppure 4 cartucce (una per il nero; una per il giallo e le altre per

il rosso e il blu).

Nel caso stampino in B/N possono superare anche le 100 tonalita' di

sfumature di grigio, creando effetti particolari nella stampa di immagini.

La congruenza tra prestazioni e il tipo di applicazioni per cui una stampante è

utilizzata è un fattore fondamentale per l’ottenimento delle migliori

prestazioni. Velocità e risoluzione sono parametri importanti, ma non sempre

rappresentano valori assoluti, vanno infatti presi in considerazione in base

alle specifiche esigenze dell’utente. Conoscere le tecnologie è quindi utile

per orientarsi nella scelta della stampante giusta e adatta alle proprie

necessità. Le tecnologie di stampa sono suddivise in due macrogruppi con

funzionalità e prestazioni completamente diverse tra loro: la stampa a impatto,

dove avviene un «impatto» o contatto fisico tra la testina di stampa e il

foglio e la stampa non a impatto (laser, ink-jet e trasferimento termico), che

non prevedono appunto alcun impatto per l’impressione dell’immagine sul

foglio.

Stampa a impatto

La stampa a impatto è la tecnologia più vecchia e sfrutta l’energia

meccanica attraverso una battuta che permette il trasferimento dell’inchiostro

da nastro alla carta. Il metodo di stampa può essere seriale (viene impresso su

carta un carattere per volta) o parallelo (una riga di caratteri). La testina di

stampa può essere costituita da elementi che riportano in rilievo i singoli

caratteri da stampare e che permettono di comporre l’intero carattere con una

singola battuta (è il caso del martelletto, della margherita o della pallina),

o da una matrice di aghi che permette di comporre (a punti) l’intero carattere

da stampare. Nel primo caso la qualità di stampa inferiore va a vantaggio della

velocità e della possibilità di grafica.

La qualità del carattere o della grafica è funzione del numero di aghi. Nelle

impact una notevole importanza per una buona qualità di stampa è assunta dal

tipo di inchiostro con cui viene impregnato il tessuto di cui il nastro è

costruito.

Stampa non a impatto

Alle tecnologie di stampa non ad impatto va sicuramente il merito dato del nuovo

impulso al mercato printer degli ultimi anni. Le stampanti basate su questa

tecnologia hanno conquistato il mercato grazie all’affermarsi ed al

perfezionarsi di un mix di tecnologie che vanno dalla meccanica, alla chimica,

all’ottica.

Le tecnologie di stampa non impact si suddividono, in funzione delle modalità

con cui viene impresso su carta il testo/grafico desiderato, in: getto di

inchiostro, laser, led, trasferimento termico, sublimazione, getto di cera. In

alcuni casi assume rilevante importanza, per la stampa e la qualità della

stessa, il tipo di «carta» utilizzato.

Getto d’inchiostro

La stampa a getto di inchiostro, o ink-jet, è una tecnologia di stampa a punti,

senza impatto, che utilizza un dispositivo che, sottoposto a sollecitazioni

elettriche, spruzza inchiostro sulla carta costruendo per punti il carattere,

secondo una matrice prestabilita.

Il dispositivo di stampa (testina) è costituito da un sistema di microugelli da

cui fuoriesce l’inchiostro che va depositato sulla carta. Esistono due

categorie definite ink-jet Continuos (stampa a flusso continuo) e ink-jet on

demand (stampa a goccia, che comprende la tecnologia getto a bolle ed il sistema

piezoelettrico).

Nella stampa a flusso continuo la testina di stampa dirige continuamente le

goccioline d’inchiostro verso la carta, ed il getto viene mantenuto da una

apposita pompa. E’ un sistema relativamente semplice dal punto di vista